AI Toolkitでモデルを探す

AI Toolkitは、Small Language Models(SLM)とLarge Language Models(LLM)の両方を含む、多種多様な生成AIモデルを包括的にサポートします。

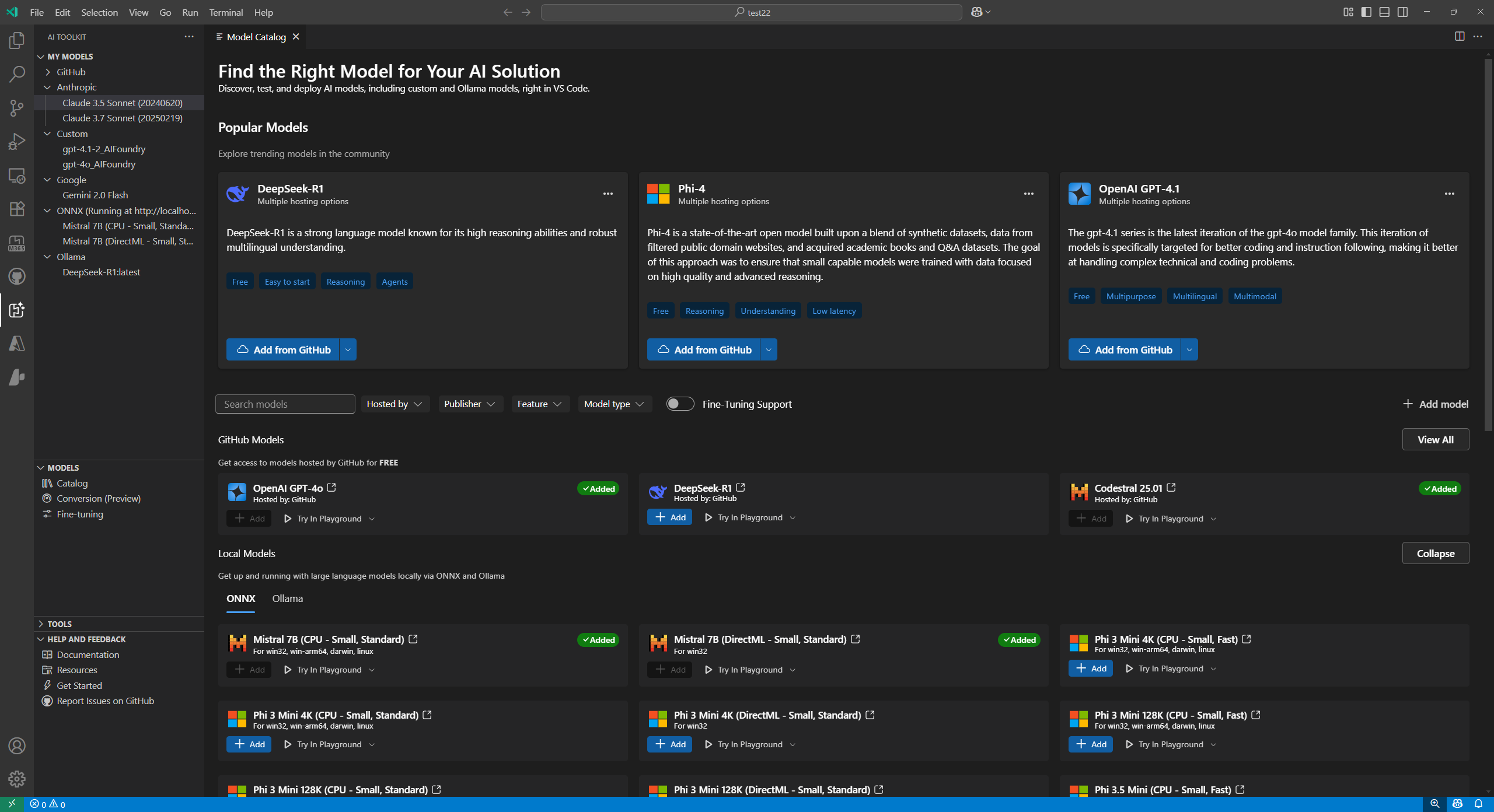

モデルカタログでは、複数のホスティングソースからモデルを探索し、利用できます。

- GitHubでホストされているモデル(Llama3、Phi-3、Mistralなど)には、従量課金制のオプションも含まれます。

- OpenAIのChatGPT、AnthropicのClaude、GoogleのGeminiなど、パブリッシャーから直接提供されるモデル。

- Azure AI Foundryでホストされているモデル。

- OllamaやONNXなどのリポジトリからローカルにダウンロードされたモデル。

- Bring-Your-Own-Model(BYOM)統合を介してアクセスできる、カスタムの自己ホスト型または外部デプロイ型モデル。

モデルカタログ内から直接Azure AI Foundryにモデルをデプロイし、ワークフローを合理化します。

Azure AI Foundry、Foundry Local、およびAI Toolkitに追加されたGitHubモデルをGitHub Copilotで使用します。詳細については、「チャット会話のモデルを変更する」を確認してください。

モデルを見つける

モデルカタログでモデルを見つけるには

-

アクティビティバーでAI Toolkitビューを選択します。

-

MODELS > Catalogを選択して、モデルカタログを開きます。

-

フィルターを使用して、利用可能なモデルのリストを絞り込みます。

- Hosted by:AI Toolkitは、GitHub、ONNX、OpenAI、Anthropic、Googleをモデルのホスティングソースとしてサポートしています。

- Publisher:Microsoft、Meta、Google、OpenAI、Anthropic、Mistral AIなど、AIモデルのパブリッシャー。

- Feature:

Text Attachment、Image Attachment、Web Search、Structured Outputsなど、モデルのサポートされる機能。 - Model type:CPU、GPU、またはNPUでリモートまたはローカルで実行できるモデルをフィルターします。このフィルターは、ローカルの可用性によって異なります。

- Fine-tuning Support:ファインチューニングを実行するために使用できるモデルを表示します。

-

次のようなさまざまなカテゴリでモデルを参照します。

- Popular Modelsは、さまざまなタスクやドメインで広く使用されているモデルの厳選されたリストです。

- GitHub Modelsは、GitHubでホストされている人気モデルに簡単にアクセスできます。高速プロトタイピングや実験に最適です。

- ONNX Modelsは、ローカル実行用に最適化されており、CPU、GPU、またはNPUで実行できます。

- Ollama Modelsは、Ollamaでローカルに実行できる人気モデルで、GGUF量子化を介してCPUをサポートしています。

-

または、検索ボックスを使用して、名前または説明で特定のモデルを検索します。

カタログからモデルを追加する

モデルカタログからモデルを追加するには

-

モデルカタログで追加したいモデルを見つけます。

-

モデルカードのAddを選択します。

-

モデルを追加するフローは、プロバイダーによって若干異なります。

-

GitHub:AI Toolkitは、モデルリポジトリにアクセスするためにGitHubの認証情報を要求します。認証後、モデルはAI Toolkitに直接追加されます。

注AI ToolkitはGitHubの従量課金制モデルをサポートするようになったため、無料ティアの制限を超えても作業を継続できます。

-

ONNX:モデルはONNXからダウンロードされ、AI Toolkitに追加されます。

-

Ollama:モデルはOllamaからダウンロードされ、AI Toolkitに追加されます。

ヒントAPIキーは、モデルを右クリックしてEditを選択すると、後で編集でき、暗号化された値は

${HOME}/.aikt/models/my-models/ymlファイルで確認できます。

-

OpenAI、Anthropic、およびGoogle:AI ToolkitはAPIキーを入力するように促します。

-

Custom models:詳細な手順については、「カスタムモデルを追加する」セクションを参照してください。

-

追加すると、モデルはツリービューのMY MODELSの下に表示され、PlaygroundまたはAgent Builderで使用できます。

カスタムモデルを追加する

外部でホストされている、またはローカルで実行されている独自のモデルを追加することもできます。いくつかのオプションが利用可能です。

- OllamaライブラリまたはカスタムOllamaエンドポイントからOllamaモデルを追加します。

- 自己ホスト型モデルやクラウドサービスで実行されているモデルなど、OpenAI互換のエンドポイントを持つカスタムモデルを追加します。

- AI Toolkitのモデル変換ツールを使用して、Hugging FaceなどのカスタムONNXモデルを追加します。

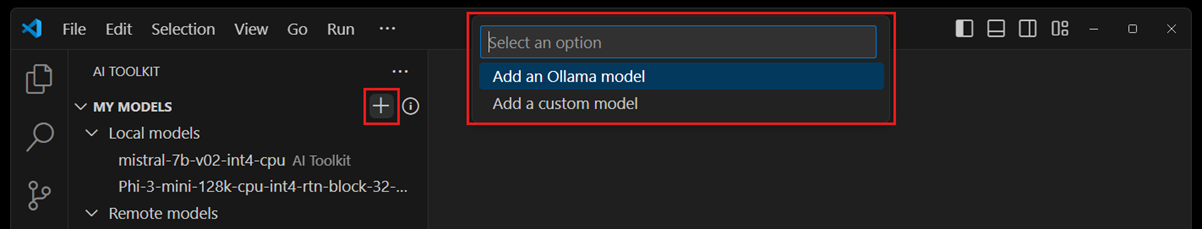

AI Toolkitにモデルを追加するためのエントリポイントがいくつかあります。

-

ツリービューのMY MODELSから、その上にマウスを移動し、

+アイコンを選択します。![モデルカタログのツールバーを示すAI Toolkitインターフェースのスクリーンショットで、[+ Add model]ボタンがハイライトされており、ユーザーが新しいカスタムモデルを追加するためにクリックできる場所を示しています。](/assets/docs/intelligentapps/models/custom-1.png)

-

モデルカタログから、ツールバーの+ Add modelボタンを選択します。

![モデルカタログのツールバーを示すAI Toolkitインターフェースのスクリーンショットで、[+ Add model]ボタンがハイライトされています。ツールバーはカタログビューの上部にあり、[+ Add model]ボタンは、ユーザーが新しいカスタムモデルを追加するためにクリックできる場所を示すために強調表示されています。](/assets/docs/intelligentapps/models/custom-2.png)

-

モデルカタログのAdd Custom Modelsセクションから、+ Add Your Own Modelを選択します。

![モデルカタログの[Custom Models]セクションを示すAI Toolkitインターフェースのスクリーンショット。 [+ Add model]ボタンがハイライトされており、ユーザーが新しいカスタムモデルを追加するためにクリックできる場所を示しています。](/assets/docs/intelligentapps/models/custom-3.png)

Ollamaモデルを追加する

Ollamaは、GGUF量子化を介して多くの人気のあるgenAIモデルをCPUでローカルに実行できるようにします。ローカルマシンにOllamaがインストールされており、Ollamaモデルがダウンロードされている場合は、それらをAI Toolkitに追加してモデルプレイグラウンドで使用できます。

AI ToolkitでOllamaモデルを使用するための前提条件

- AI Toolkit v0.6.2以降。

- Ollama (Ollama v0.4.1でテスト済み)

ローカルのOllamaをAI Toolkitに追加するには

-

上記のいずれかのエントリポイントから、Add Ollama Modelを選択します。

-

次に、Select models from Ollama libraryを選択します。

Ollamaランタイムを別のエンドポイントで起動する場合は、Provide custom Ollama endpointを選択してOllamaエンドポイントを指定します。

-

AI Toolkitに追加するモデルを選択し、OKを選択します。

注AI Toolkitは、Ollamaにすでにダウンロードされており、まだAI Toolkitに追加されていないモデルのみを表示します。Ollamaからモデルをダウンロードするには、

ollama pullを実行できます。Ollamaでサポートされているモデルのリストについては、Ollamaライブラリを参照するか、Ollamaドキュメントを参照してください。 -

選択したOllamaモデルがツリービューのモデルリストに表示されるはずです。

注Ollamaモデルのアタッチメントはまだサポートされていません。これは、OpenAI互換のエンドポイント(https://github.com/ollama/ollama/blob/main/docs/openai.md)を使用してOllamaに接続しているためであり、まだアタッチメントをサポートしていません。

OpenAI互換のエンドポイントを持つカスタムモデルを追加する

インターネットからアクセスできるOpenAI互換のエンドポイントを持つ自己ホスト型またはデプロイされたモデルがある場合は、それをAI Toolkitに追加してプレイグラウンドで使用できます。

- 上記のいずれかのエントリポイントから、Add Custom Modelを選択します。

- OpenAI互換のエンドポイントURLと必要な情報を入力します。

自己ホスト型またはローカルで実行されているOllamaモデルを追加するには

- モデルカタログで+ Add modelを選択します。

- モデルクイックピックで、OllamaまたはCustom modelを選択します。

- モデルを追加するために必要な詳細を入力します。

カスタムONNXモデルを追加する

カスタムONNXモデルを追加するには、まずモデル変換ツールを使用してAI Toolkitモデル形式に変換します。変換後、モデルをAI Toolkitに追加します。

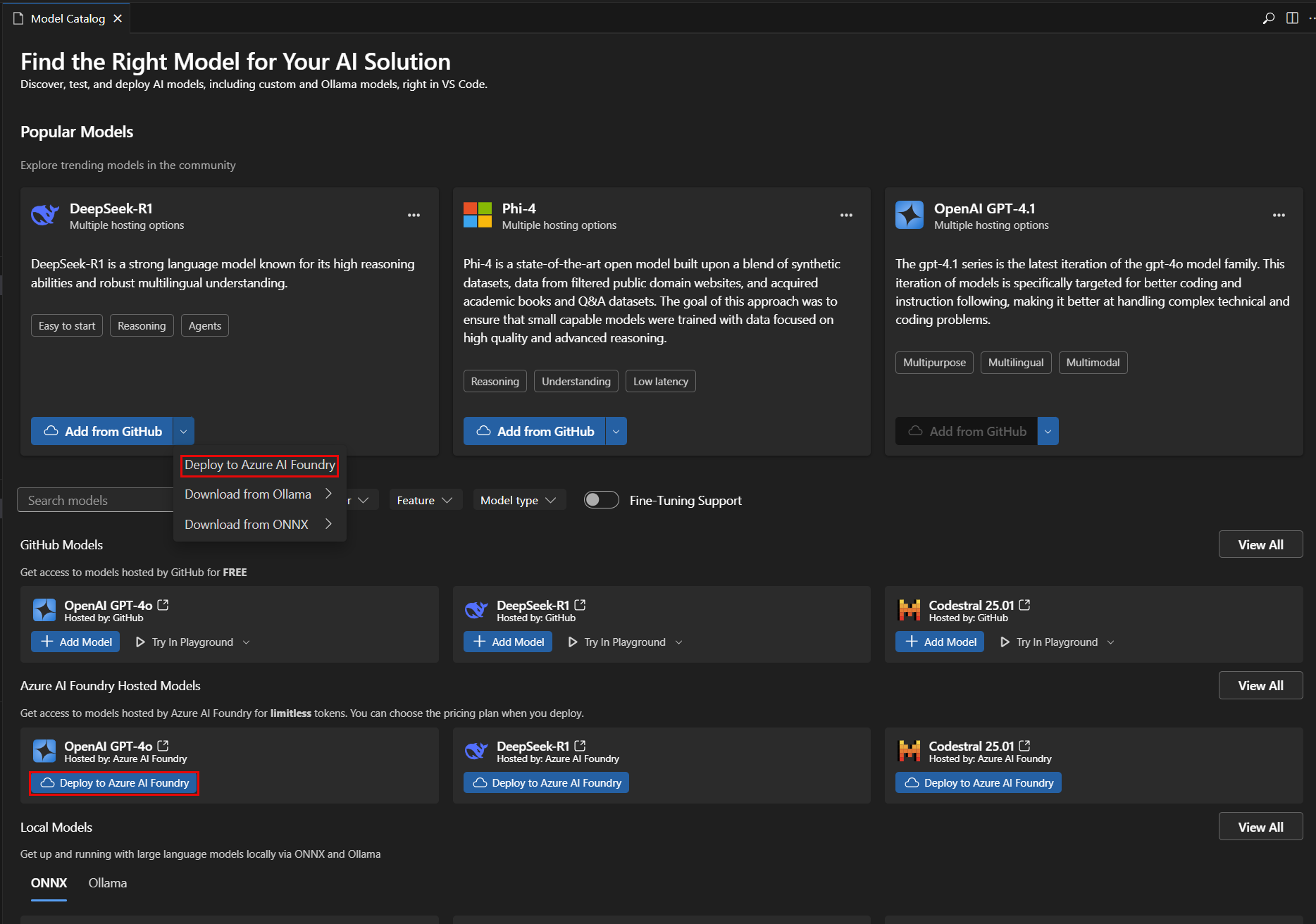

Azure AI Foundryにモデルをデプロイする

AI Toolkitから直接Azure AI Foundryにモデルをデプロイできます。これにより、クラウドでモデルを実行し、エンドポイントを介してアクセスできます。

-

モデルカタログから、デプロイしたいモデルを選択します。

-

次のスクリーンショットに示すように、ドロップダウンメニューまたはDeploy to Azure AI Foundryボタンから直接、Deploy to Azure AI Foundryを選択します。

-

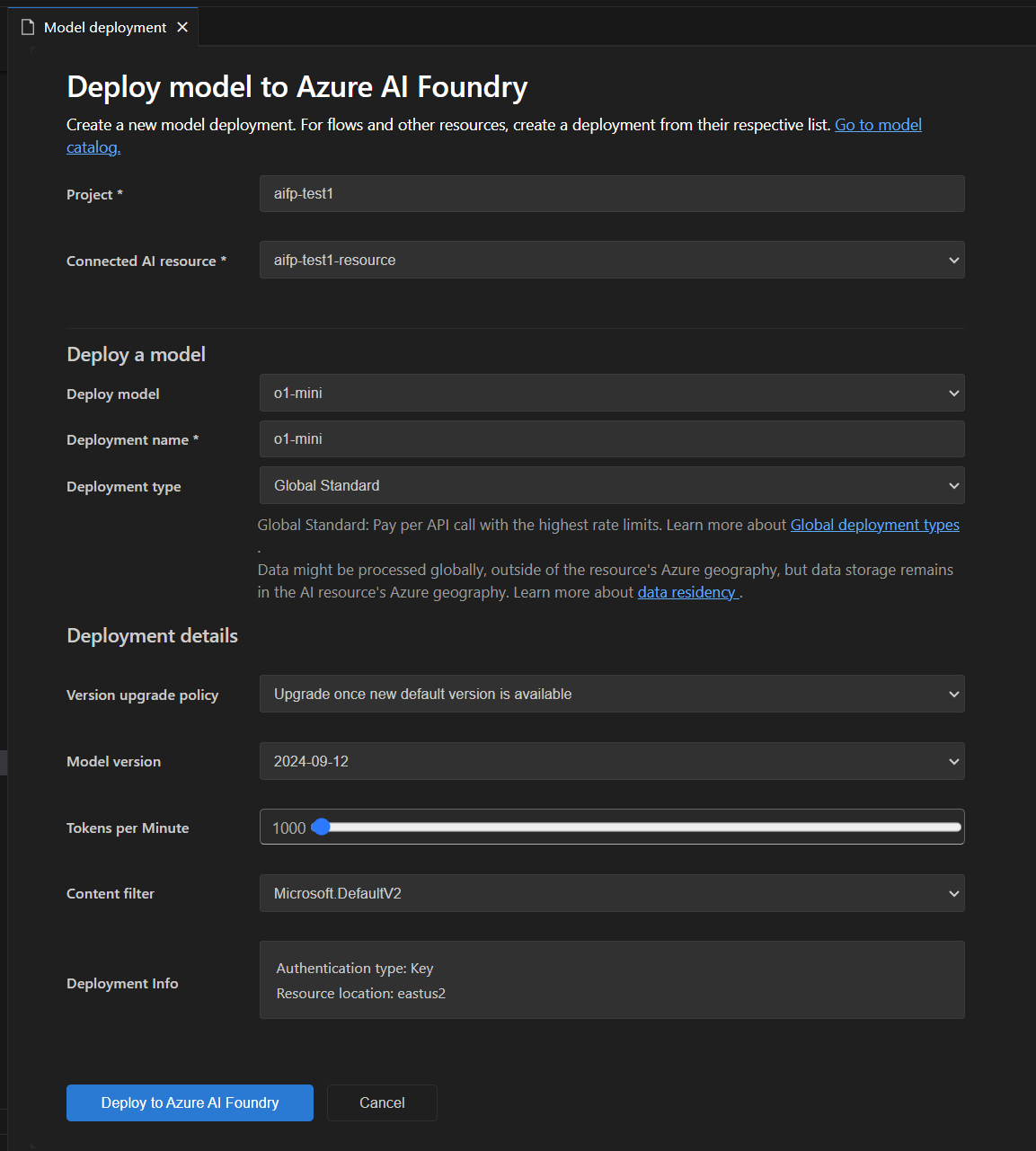

次のスクリーンショットに示すように、model deploymentタブで、モデル名、説明、および追加設定などの必要な情報を入力します。

-

Deploy to Azure AI Foundryを選択して、デプロイプロセスを開始します。

-

デプロイを確認するためのダイアログが表示されます。詳細を確認し、Deployを選択して続行します。

-

デプロイが完了すると、モデルはAI ToolkitのMY MODELSセクションで利用可能になり、プレイグラウンドまたはエージェントビルダーで使用できます。

テスト用のモデルを選択する

プレイグラウンドでチャット補完用のモデルをテストできます。

モデルカタログのモデルカードのアクションを使用する

- Try in Playground:選択したモデルをPlaygroundにロードしてテストします。

- Try in Agent Builder:選択したモデルをAgent BuilderにロードしてAIエージェントを構築します。

モデルを管理する

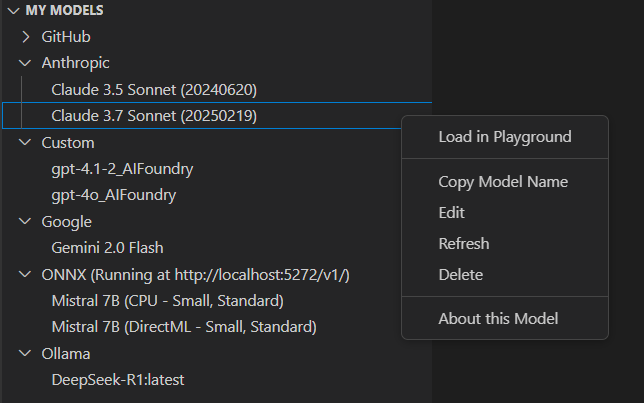

AI ToolkitビューのMY MODELSセクションでモデルを管理できます。ここでは、次のことができます。

-

AI Toolkitに追加したモデルのリストを表示します。

-

モデルを右クリックして、次のようなオプションにアクセスします。

- Load in Playground:モデルをPlaygroundにロードしてテストします。

- Copy Model Name:モデル名をクリップボードにコピーして、コード統合などの他のコンテキストで使用します。

- Refresh:モデル構成を更新して、最新の設定を確実に適用します。

- Edit:APIキーやエンドポイントなど、モデル設定を変更します。

- Delete:AI Toolkitからモデルを削除します。

- About this Model:パブリッシャー、ソース、サポートされる機能など、モデルに関する詳細情報を表示します。

-

ONNXセクションタイトルを右クリックして、次のようなオプションにアクセスします。- Start Server:ONNXサーバーを起動して、ONNXモデルをローカルで実行します。

- Stop Server:ONNXサーバーが実行中の場合は停止します。

- Copy Endpoint:ONNXサーバーエンドポイントをクリップボードにコピーして、コード統合などの他のコンテキストで使用します。

ライセンスとサインイン

一部のモデルでは、パブリッシャーまたはホスティングサービスのライセンスとアカウントへのサインインが必要です。その場合、モデルプレイグラウンドでモデルを実行する前に、この情報の提供を求められます。

学んだこと

この記事では、次のことを学びました

- AI Toolkitで生成AIモデルを探索および管理します。

- GitHub、ONNX、OpenAI、Anthropic、Google、Ollama、カスタムエンドポイントなど、さまざまなソースからモデルを見つけます。

- ツールキットにモデルを追加し、Azure AI Foundryにデプロイします。

- OllamaおよびOpenAI互換モデルを含むカスタムモデルを追加し、プレイグラウンドまたはエージェントビルダーでテストします。

- モデルカタログを使用して利用可能なモデルを表示し、AIアプリケーションのニーズに最適なものを選択します。

- フィルターと検索を使用して、モデルをすばやく見つけます。

- Popular、GitHub、ONNX、Ollamaなどのカテゴリでモデルを参照します。

- モデル変換ツールを使用して、カスタムONNXモデルを変換および追加します。

- MY MODELSでモデルを管理します。これには、編集、削除、更新、詳細の表示が含まれます。

- ONNXサーバーを起動および停止し、ローカルモデルのエンドポイントをコピーします。

- テストする前に、一部のモデルのライセンスとサインイン要件を処理します。