AI Toolkit FAQ

モデル

リモートモデルのエンドポイントと認証ヘッダーはどのように見つけられますか?

一般的なOpenAIサービスプロバイダーでエンドポイントと認証ヘッダーを見つける方法の例をいくつか示します。その他のプロバイダーについては、チャット完了エンドポイントと認証ヘッダーに関するドキュメントを確認してください。

例1:Azure OpenAI

-

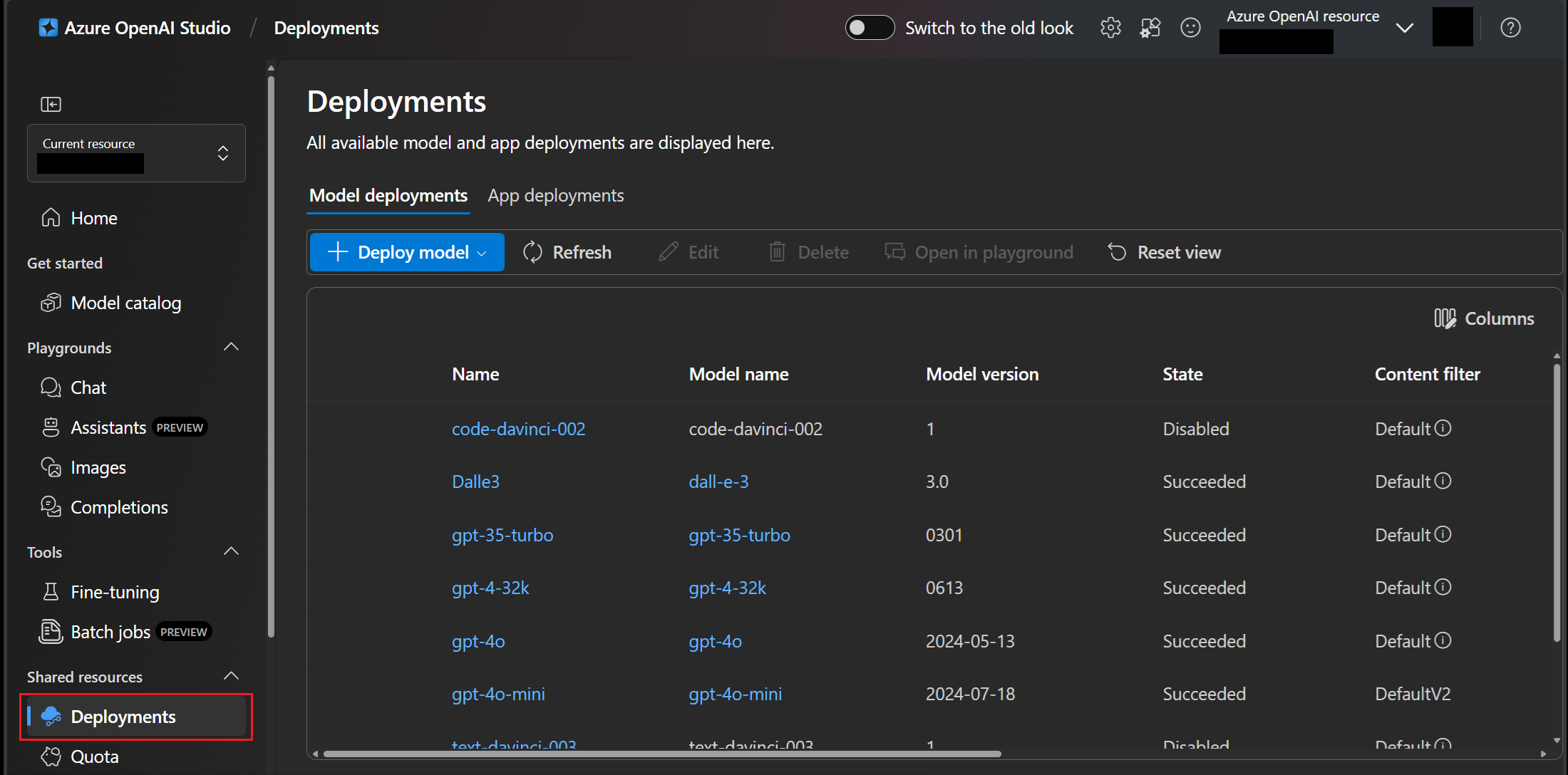

Azure OpenAI Studioのデプロイメントブレードに移動し、例えば

gpt-4oなど、デプロイメントを選択します。まだデプロイメントがない場合は、デプロイメントの作成方法に関するAzure OpenAIドキュメントを確認してください。

-

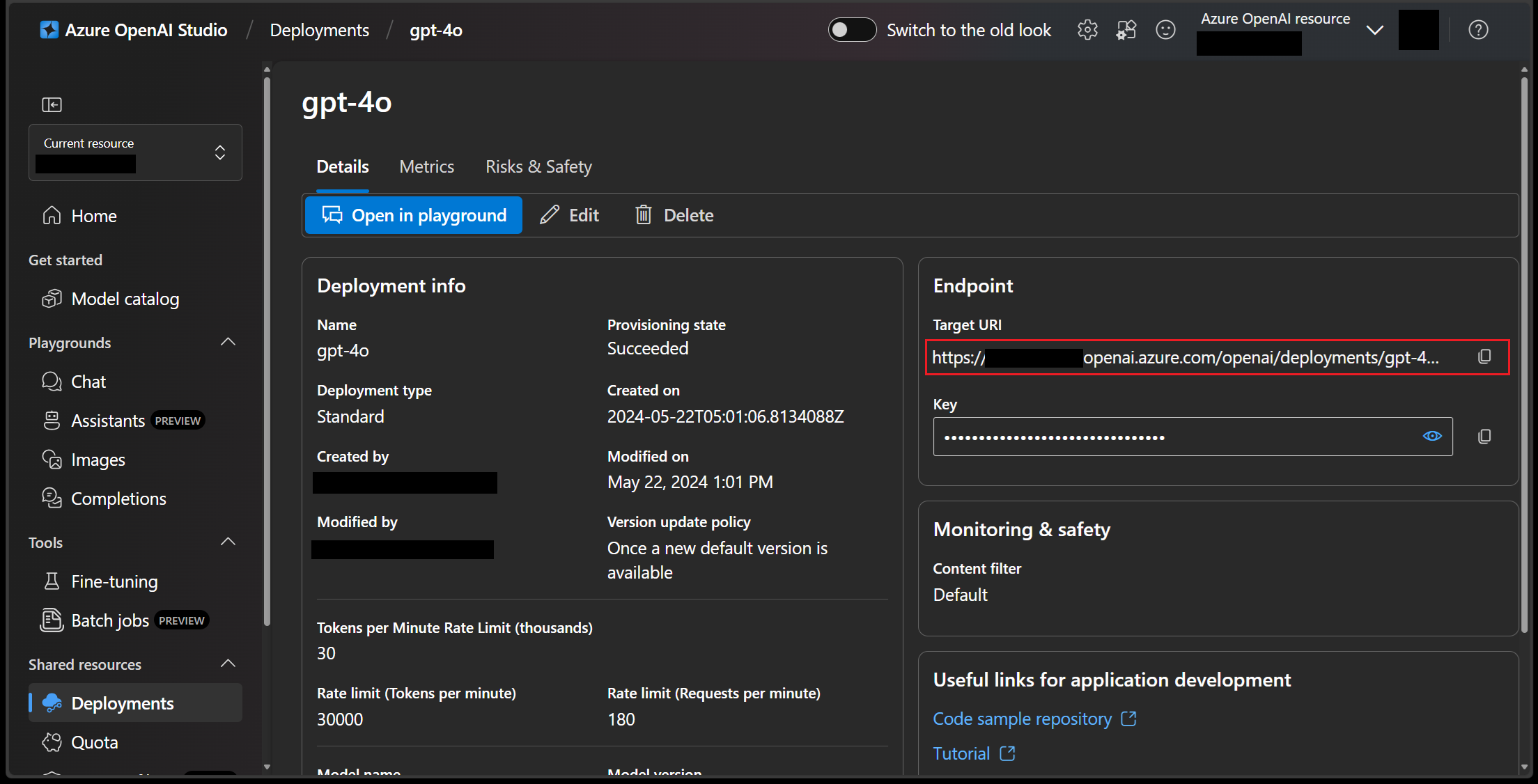

エンドポイントセクションのターゲットURIフィールドでチャット完了エンドポイントを取得します。

-

エンドポイントセクションのキープロパティからAPIキーを取得します。

APIキーをコピーしたら、AI Toolkitの認証ヘッダーとして

api-key: <YOUR_API_KEY>の形式で追加します。認証ヘッダーの詳細については、Azure OpenAIサービスドキュメントを参照してください。

例2:OpenAI

-

現時点では、チャット完了エンドポイントは

https://api.openai.com/v1/chat/completionsに固定されています。詳細については、OpenAIドキュメントを参照してください。 -

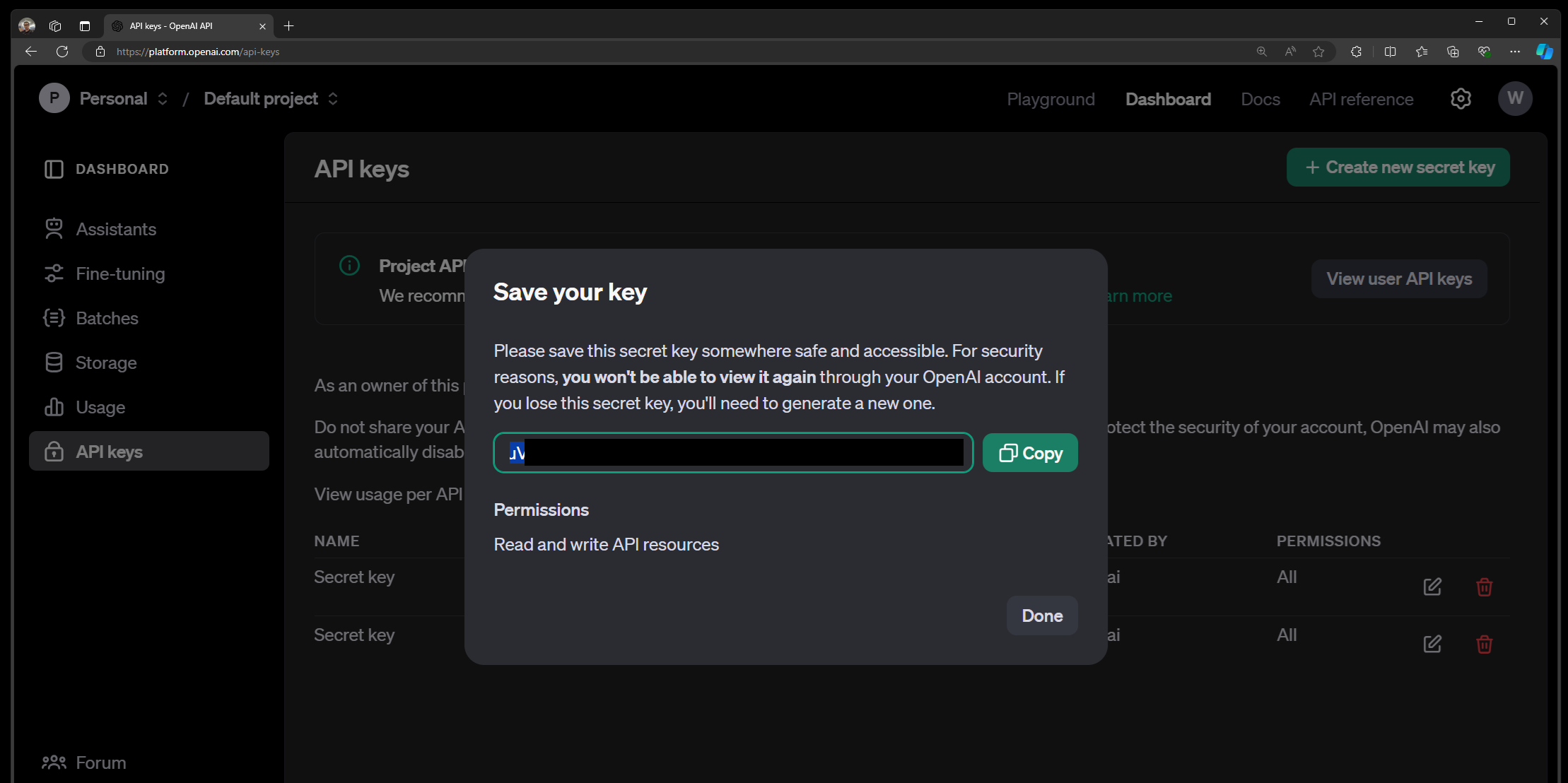

OpenAIドキュメントに移動し、

API KeysまたはProject API Keysを選択してAPIキーを作成または取得します。APIキーをコピーしたら、AI Toolkitの認証ヘッダーとして

Authorization: Bearer <YOUR_API_KEY>の形式で入力します。詳細については、OpenAIドキュメントを参照してください。

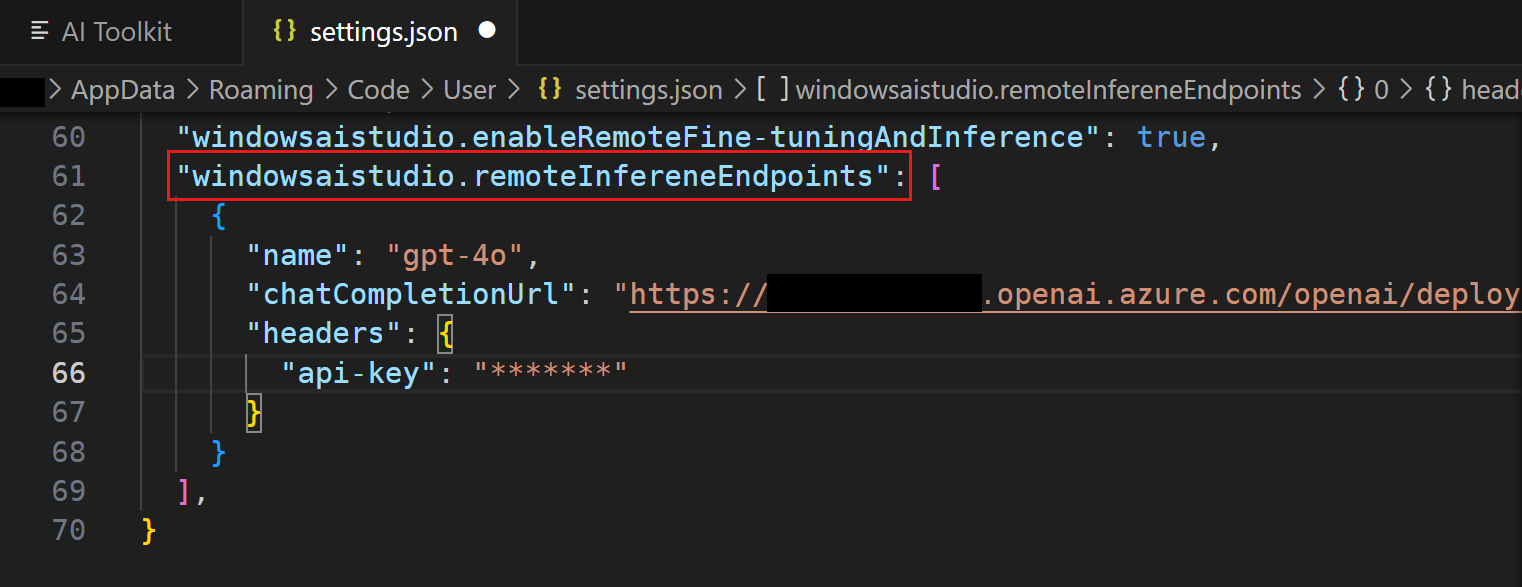

エンドポイントURLまたは認証ヘッダーを編集する方法

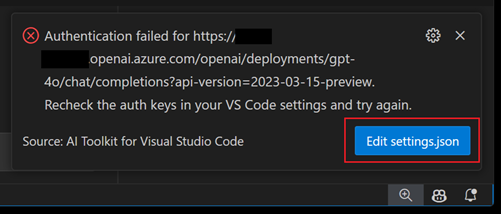

間違ったエンドポイントまたは認証ヘッダーを入力すると、推論でエラーが発生する可能性があります。

-

VS Codeの

setting.jsonファイルを開きます。-

認証失敗通知で

Edit settings.jsonを選択します。

-

または、コマンドパレット(⇧⌘P(Windows、Linux Ctrl+Shift+P))で

Open User Settings (JSON)と入力します。

-

-

windowsaistudio.remoteInfereneEndpoints設定を検索します。 -

既存のエンドポイントURLまたは認証ヘッダーを編集または削除します。

設定を保存すると、ツリービューまたはプレイグラウンドのモデルリストが自動的に更新されます。

OpenAI o1-miniまたはOpenAI o1-previewの待機リストに参加するにはどうすればよいですか?

OpenAI o1シリーズのモデルは、推論と問題解決タスクに特化して設計されており、集中力と能力が向上しています。これらのモデルは、ユーザーのリクエストの処理と理解により多くの時間を費やすため、科学、コーディング、数学などの分野で非常に優れています。例えば、o1は、医療研究者が細胞シーケンスデータに注釈を付けるために、物理学者が量子光学に必要な複雑な数式を生成するために、そしてあらゆる分野の開発者が多段階ワークフローを構築および実行するために使用できます。

o1-previewモデルは、限定されたアクセスで利用できます。プレイグラウンドでモデルを試すには登録が必要であり、Microsoftの資格基準に基づいてアクセスが許可されます。

OpenAI o1-miniまたはOpenAI o1-previewを見つけて待機リストに参加するには、GitHubモデルマーケットにアクセスしてください。

独自のモデルやHugging Faceの他のモデルを使用できますか?

独自のモデルがOpenAI API契約をサポートしている場合、それをクラウドでホストし、カスタムモデルとしてAI Toolkitにモデルを追加できます。モデルエンドポイントURL、アクセスキー、モデル名などの主要情報を提供する必要があります。

ファインチューニング

多くのファインチューニング設定があります。それらすべてを気にする必要がありますか?

いいえ、デフォルト設定とテスト用のサンプルデータセットで実行するだけでかまいません。独自のデータセットを選択することもできますが、いくつかの設定を調整する必要があります。詳細については、ファインチューニングチュートリアルを参照してください。

AI Toolkitはファインチューニングプロジェクトをスキャフォールドしません

拡張機能をインストールする前に、拡張機能の前提条件を確認してください。

NVIDIA GPUデバイスがありますが、前提条件チェックが失敗します

NVIDIA GPUデバイスがあるにもかかわらず、「GPUが検出されません」という前提条件チェックが失敗する場合は、最新のドライバーがインストールされていることを確認してください。ドライバーはNVIDIAサイトで確認およびダウンロードできます。

また、パスにインストールされていることを確認してください。確認するには、コマンドラインからnvidia-smiを実行します。

プロジェクトを生成しましたが、Conda activateが環境を見つけられません

環境設定に問題があった可能性があります。ワークスペース内からbash /mnt/[PROJECT_PATH]/setup/first_time_setup.shを使用して、手動で環境を初期化できます。

Hugging Faceデータセットを使用する場合、どのように取得しますか?

python finetuning/invoke_olive.pyコマンドを開始する前に、huggingface-cli loginコマンドを実行していることを確認してください。これにより、データセットがユーザーに代わってダウンロードされることが保証されます。

環境

拡張機能はLinuxや他のシステムで動作しますか?

はい、AI ToolkitはWindows、Mac、Linuxで動作します。

WSLからCondaの自動アクティベーションを無効にするにはどうすればよいですか?

WSLでCondaのインストールを無効にするには、conda config --set auto_activate_base falseを実行します。これにより、基本環境が無効になります。

コンテナは現在サポートされていますか?

現在、コンテナのサポートに取り組んでおり、将来のリリースで有効になる予定です。

GitHubとHugging Faceの資格情報が必要なのはなぜですか?

すべてのプロジェクトテンプレートはGitHubでホストされ、ベースモデルはAzureまたはHugging Faceでホストされています。これらの環境にAPIからアクセスするにはアカウントが必要です。

Llama2のダウンロードでエラーが発生しています

Metaの貿易規制に準拠するために、Llama 2サインアップページからLlamaへのアクセスをリクエストしていることを確認してください。

WSLインスタンス内にプロジェクトを保存できません

AI Toolkitアクションの実行中にリモートセッションが現在サポートされていないため、WSLに接続した状態ではプロジェクトを保存できません。リモート接続を閉じるには、画面左下の「WSL」を選択し、「リモート接続を閉じる」を選択します。

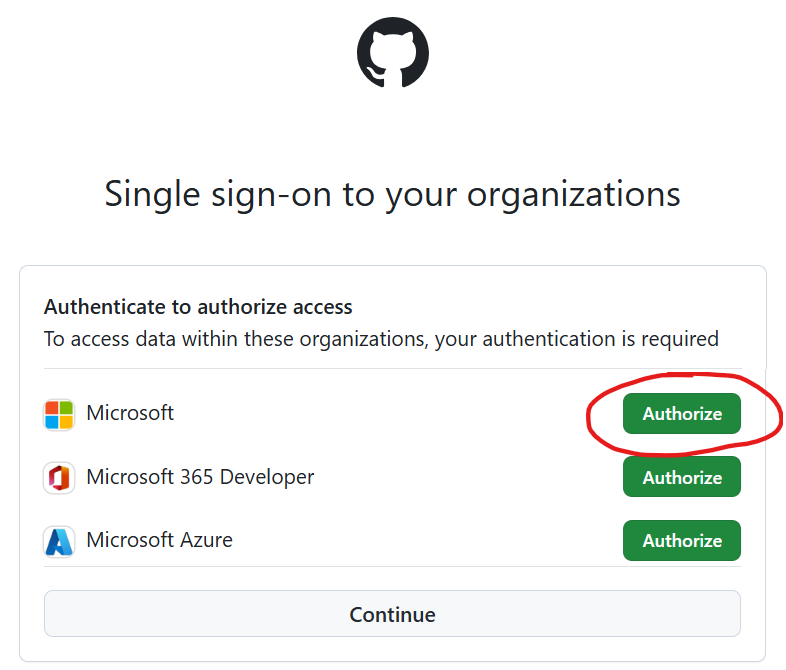

エラー: GitHub APIが禁止されています

プロジェクトテンプレートはmicrosoft/windows-ai-studio-templatesGitHubリポジトリでホストされており、拡張機能はGitHub APIを使用してリポジトリコンテンツをロードします。Microsoftの内部にいる場合、このような禁止問題を回避するためにMicrosoft組織を承認する必要があるかもしれません。

回避策についてはこの問題を参照してください。詳細な手順は以下のとおりです。

-

VS CodeからGitHubアカウントをサインアウトします。

-

VS CodeとAI Toolkitをリロードすると、再度GitHubにサインインするように求められます。

-

重要:ブラウザの承認ページで、アプリがMicrosoft組織にアクセスすることを必ず承認してください。

ONNXモデルを一覧表示、ロード、またはダウンロードできません

VS Codeの出力パネルでAI Toolkitログを確認してください。「Agentエラー」または「Failed to get downloaded models」が表示された場合は、すべてのVS Codeインスタンスを閉じて、VS Codeを再度開いてください。

(この問題は、基盤となるONNXエージェントが予期せず終了したことが原因であり、上記の手順はエージェントを再起動するためのものです。)