AIツールキットのプロンプトエンジニアリング

AIツールキットのプロンプトビルダーは、プロンプトエンジニアリングのワークフローを効率化します。スタータープロンプトを生成し、実行ごとに反復して洗練させ、プロンプトチェーンと構造化された出力を通じて複雑なタスクを分解し、API を介したシームレスな大規模言語モデル (LLM) 統合のためのコードに簡単にアクセスできるようにします。

プロンプトの作成、編集、およびテスト

プロンプトビルダーにアクセスするには、次のいずれかのオプションを使用します

- AIツールキットビューで、[プロンプトビルダー] を選択します

- モデルカタログのモデルカードから [プロンプトビルダーで試す] を選択します

プロンプトビルダーでプロンプトをテストするには、次の手順に従います

-

[モデル] で、ドロップダウンリストからモデルを選択するか、[モデルの参照] を選択して、モデルカタログから別のモデルを追加します。

-

[ユーザープロンプト] を入力し、オプションで [システムプロンプト] を入力します。

ユーザープロンプトは、モデルに送信する入力です。オプションのシステムプロンプトは、モデルの応答を誘導するために、関連するコンテキストとともに指示を提供するために使用されます。

ヒントこれらのプロンプトの入力方法がわからない場合は、プロジェクトのアイデアを自然言語で記述し、AI 搭載機能にプロンプトを生成させて実験できます。

-

[実行] を選択して、プロンプトを選択したモデルに送信します。

-

オプションで、[プロンプトを追加] を選択して、会話にユーザーとアシスタントのプロンプトを追加するか、[応答をアシスタントプロンプトとして使用] を選択して、モデルの動作をさらに誘導するためにモデルに送信する履歴とコンテキストとして使用します。

-

前の手順を繰り返して、モデルの応答を観察し、プロンプトに変更を加えることで、プロンプトを反復処理します。

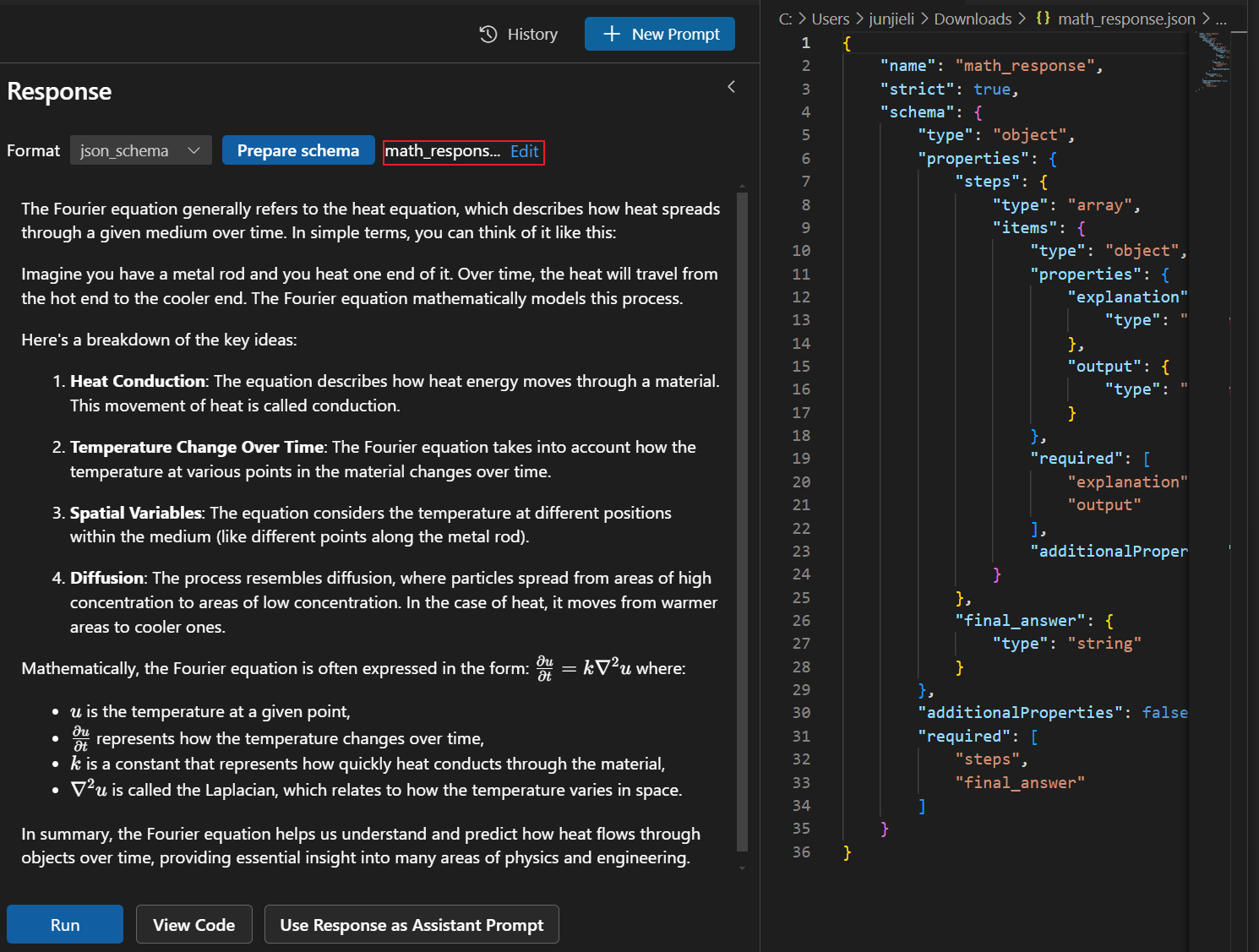

構造化された出力

構造化された出力のサポートは、構造化された予測可能な形式で出力を提供するプロンプトを設計するのに役立ちます。

プロンプトビルダーでプロンプトをテストするには、次の手順に従います

-

[応答] 領域の [形式] ドロップダウンを選択し、[json_schema] を選択します。

-

[スキーマを準備] を選択し、次に [ローカルファイルを選択] を選択して独自のスキーマを使用するか、[例を使用] を選択して定義済みのスキーマを使用します。

例を使用する場合は、ドロップダウンリストからスキーマを選択できます。

-

[実行] を選択して、プロンプトを選択したモデルに送信します。

-

[編集] を選択してスキーマを編集することもできます。

プロンプトエンジニアリングをアプリケーションに統合する

モデルとプロンプトを試した後、自動的に生成された Python コードですぐにコーディングを開始できます。

Python コードを表示するには、次の手順に従います

-

[コードを表示] を選択します。

-

GitHub でホストされているモデルの場合は、使用する推論 SDK を選択します。

AI ツールキットは、プロバイダーのクライアント SDK を使用して、選択したモデルのコードを生成します。GitHub でホストされているモデルの場合、使用する推論 SDK を選択できます: Azure AI Inference SDK、または OpenAI SDK や Mistral API などのモデルプロバイダーの SDK です。

-

生成されたコードスニペットは、新しいエディターに表示され、アプリケーションにコピーできます。

モデルで認証するには、通常、プロバイダーからの API キーが必要です。GitHub でホストされているモデルにアクセスするには、GitHub 設定で パーソナルアクセストークン (PAT) を生成します。